Colloquium d’Informatique de Sorbonne Université

Léon Bottou, Facebook AI Research

Mardi 6 mars 2018 18 h

Amphi 25 Sorbonne Université - Faculté des Sciences

Une approche géométrique de l'apprentissage non supervisé

Leon Bottou reçut son Diplome d'Ingénieur de l'École Polytechnique (X84) en 1987, un Magistère de Mathématiques Fondamentales et Appliquées et d'Informatique de l'École Normale Supérieure en 1988, et un doctorat en informatique à l'Université de Paris-Sud en 1991. Son itinéraire professionnel est passé par AT&T Bell Labs, AT&T Labs, NEC Lab et Microsoft Research. Il a rejoint Facebook AI Research en 2015. Son objectif à long terme est de comprendre ce qu'est l'intelligence et comment on peut la reproduire. Bien que cet objectif demande des avancées conceptuelles que l'on ne peut pas encore anticiper, il est certainement nécessaire de comprendre comment on apprend et comment on raisonne. Ses contributions les plus connues sont son travail sur les réseaux profonds dans les années 1990, son travail sur l'apprentissage à grande échelle et les algorithmes stochastiques dans les années 2000, et, peut-être, ses travaux plus recents sur l'inférence causale en apprentissage automatique. Léon est aussi l'auteur principal du système de compression de documents DjVu.

Résumé

Les avancées récentes de l'intelligence artificielle reposent sur l'apprentissage supervisé. Dans le cas le plus simple, chaque exemple d'apprentissage est étiqueté avec la réponse que la machine doit imiter. C'est ainsi que l'on construit les systèmes modernes de reconnaissance d'objets dans des images, de reconnaissance de la parole, ou de traduction automatique. Dans le cas de l'apprentissage par renforcement, la supervision consiste en une récompense qui sanctionne une séquence d'actions. Par exemple, on peut apprendre à jouer au jacquet ou aux échecs en organisant un tournoi et en récompensant les victoires. Malgré ces succès, il faut bien reconnaître que nos algorithmes utilisent des quantités d'exemples inhumaines : plus d'image qu'un humain ne peut voir en une vie entière, plus de textes traduits qu'un humain ne peut lire dans une vie entière, et plus de parties d'échecs de haut niveau que l'humanité tout entière. La clé consiste donc à comprendre l'apprentissage non supervisé. Si tout le monde s'accorde pour dire que cela consiste à utiliser des exemples d'apprentissages non étiquetés, il n'y a guère de consensus sur ce qu'une telle machine doit réaliser. Du point de vue statistique, on ne peut rien faire de plus qu'estimer la distribution de probabilité qui régit les exemples. Mais en pratique, ce que l'on recherche est souvent l'identification des mécanisme causaux qui génèrent les exemples. En particulier nous voulons former des intuitions valides au sujet de ce qui se passerait en réponse à des actions qui ne sont pas bien illustrées par les exemples d'apprentissage. Comment approcher cet objectif en apparence impossible ? Le premier pas est de montrer que la distribution de probabilité peut suggérer des relations causales. On sait bien que l'observation de corrélations n'est pas un bon indice de causalité. Il se trouve en fait que des caractéristiques plus subtiles des distributions jointes donnent des indices plus fiables. Nous montrerons cela par des exemples simples et par une étude empirique de plus grande taille qui confirme l'existence de tels indices. Le second pas est de comprendre comment reconnaître ces caractéristiques subtiles et les associer avec des modèles causaux simples. Il nous faut donc comparer la distribution observée des données avec la distribution associée à ces modèles simples. Comme ces dernières ne peuvent généralement pas être représentées par une fonction de densité, nous devons utiliser des modèles dits implicites, et des mesures de distances qui different de celles généralement utilisées pour l'estimation de densité. L'une des possibilités est la distance de Wasserstein qui donne des résultats pratiques prometteurs malgré des propriétés statistiques qui semblent désespérées en théorie. Nous proposons d'étudier plus précisément la géométrie que ces distances induisent sur l'espaces des mesures de probabilité, et nous montrons que la distance de Wasserstein donne des garanties utiles pour la convergence globale des algorithmes d'apprentissage. Cela ne prouve certainement pas que c'est la meilleure approche, mais nous espérons que cela nous aidera à trouver comment finir ce second pas et commencer le suivant.

Master Class

L'un des moment particulièrement apprécié lors du colloquium est la « Masterclass » au cours de laquelle quelques doctorants du laboratoires ont l'opportunité de présenter leurs travaux à l'invité(e). Chaque présentation est suivie d'une discussion approfondie. Le programme complet est donné dans le document suivant.

Autres informations

Comité de Pilotage

Annonce des Colloquium

Si vous souhaitez être informé des prochains événements, vous pouvez souscrire à la liste de diffusion.

Si vous ne souhaitez plus être informé des événements, vous pouvez vous désinscrire de la liste de diffusion

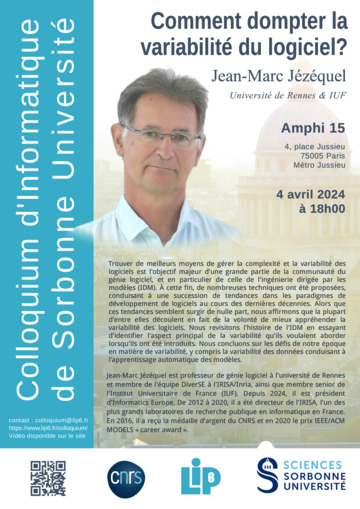

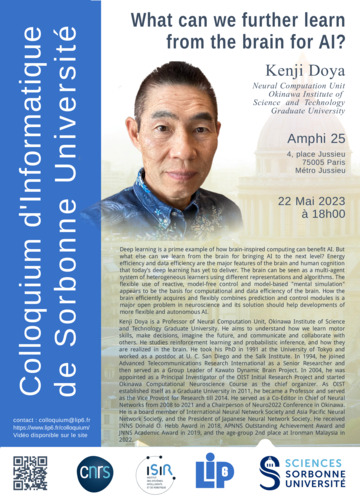

- Année 2023 – 2024

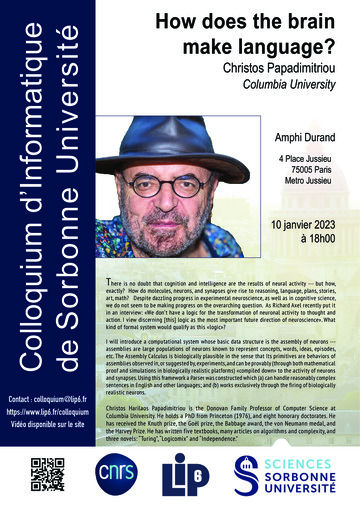

- Année 2022 – 2023

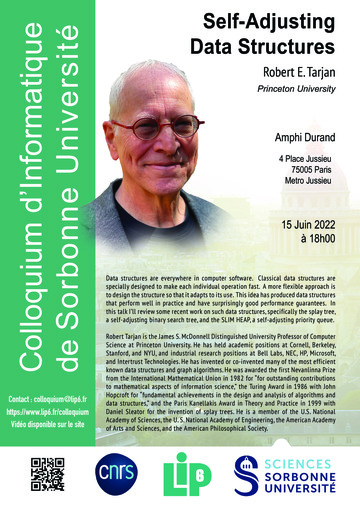

- Année 2021 – 2022

- Année 2020 – 2021

- Année 2019 – 2020

- Année 2018 – 2019

-

Cláudio T. Silva

Cláudio T. Silva

11 juin 2019

Urban Data Science -

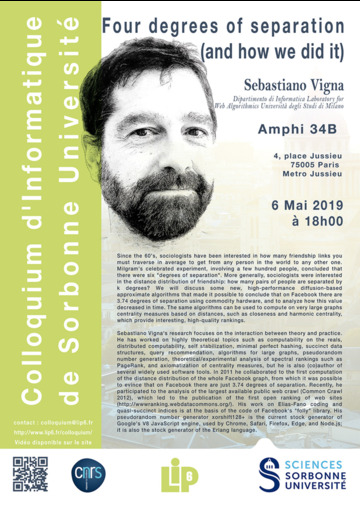

Sébastiano Vigna

Sébastiano Vigna

06 mai 2019

Four degrees of separation (and how we did it) -

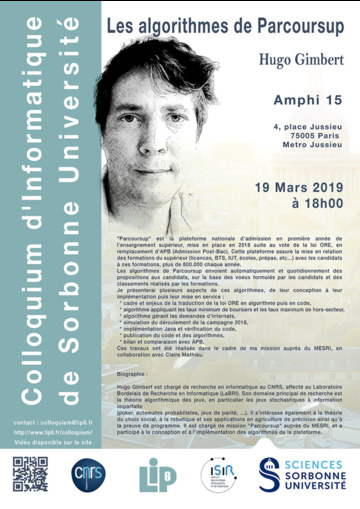

Hugo Gimbert

Hugo Gimbert

19 mars 2019

Les algorithmes de Parcoursup -

Julie Grollier

Julie Grollier

05 février 2019

Nanodevices for Bio-inspired Computing -

Jacques Pitrat

Jacques Pitrat

20 novembre 2018

L'IA forte -

James Larus

James Larus

23 octobre 2018

Programming Non-Volatile Memory

-

- Année 2017 – 2018

-

Eric Horvitz

Eric Horvitz

20 juin 2018

AI Aspirations and Advances -

Justine Cassell

Justine Cassell

15 mai 2018

Designing Bots, Virtual Humans, and Other Systems that Can Hold up Their End of the Conversation -

Léon Bottou

Léon Bottou

06 mars 2018

Une approche géométrique de l'apprentissage non supervisé -

Jean-Luc Schwartz

Jean-Luc Schwartz

16 janvier 2018

Modélisation cognitive des unités de la parole -

Timothy Roscoe

Timothy Roscoe

30 novembre 2017

The Trouble with Hardware

-

- Année 2016 – 2017

-

Simon Peyton Jones

Simon Peyton Jones

23 mai 2017

Escape from the ivory tower: the Haskell journey -

Maria Chudnovsky

Maria Chudnovsky

25 avril 2017

Induced subgraphs and coloring -

Philippa Gardner

Philippa Gardner

28 mars 2017

Understanding and Verifying JavaScript Programs -

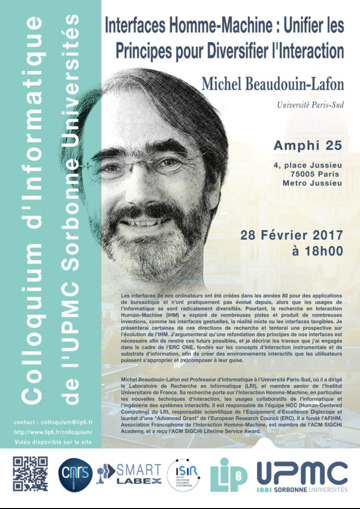

Michel Beaudoin-Lafon

Michel Beaudoin-Lafon

28 février 2017

Interfaces Homme-Machine -

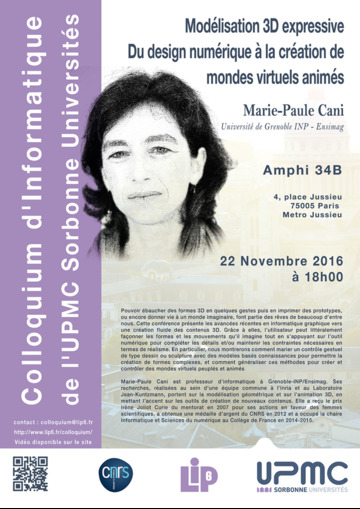

Marie-Paule Cani

Marie-Paule Cani

22 novembre 2016

Modélisation 3D expressive -

Richard Stallman

Richard Stallman

11 octobre 2016

What Makes Digital Inclusion Good Or Bad? -

Patrick Cousot

Patrick Cousot

29 septembre 2016

Abstract interpretation

-

- Année 2015 – 2016

-

Patrick Flandrin

Patrick Flandrin

16 juin 2016

« Chirps » everywhere -

Aude Billard

Aude Billard

12 avril 2016

Robots that exceed human capabilities -

Willy Zwaenepoel

Willy Zwaenepoel

22 mars 2016

Really Big Data -

Jon Crowcroft

Jon Crowcroft

19 janvier 2016

Cybersecurity and network measurement -

Isabelle Collet

Isabelle Collet

24 novembre 2015

Les informaticiennes, de la dominance de classe aux discriminations de sexe -

Xavier Leroy

Xavier Leroy

20 octobre 2015

Desperately seeking software perfection

-

- Année 2014 – 2015

-

Silvio Micali

Silvio Micali

26 mai 2015

Proofs, Secrets, and Computation -

Alessandra Carbone

Alessandra Carbone

14 avril 2015

The new era of biology is computational -

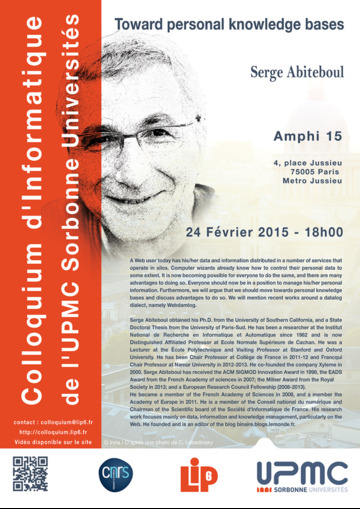

Serge Abiteboul

Serge Abiteboul

24 février 2015

Toward personal knowledge bases -

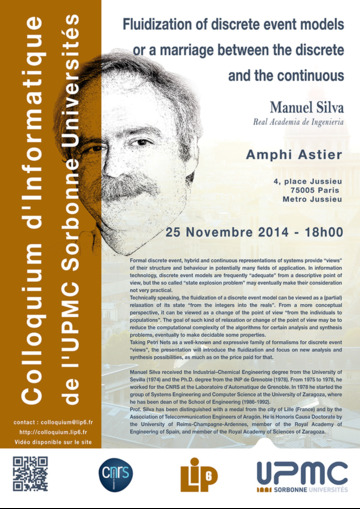

Manuel Silva

Manuel Silva

25 novembre 2014

Fluidization of discrete event models or a marriage between the discrete and the continuous -

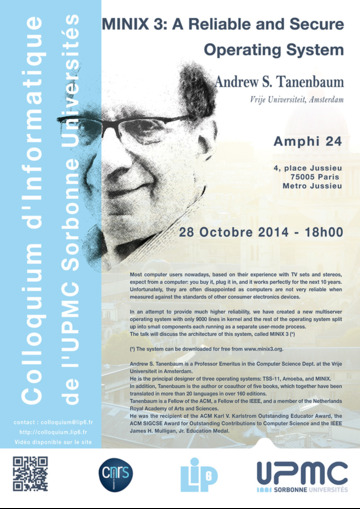

Andrew S. Tanenbaum

Andrew S. Tanenbaum

28 octobre 2014

MINIX 3: A Reliable and Secure Operating System

-

- Année 2013 – 2014

-

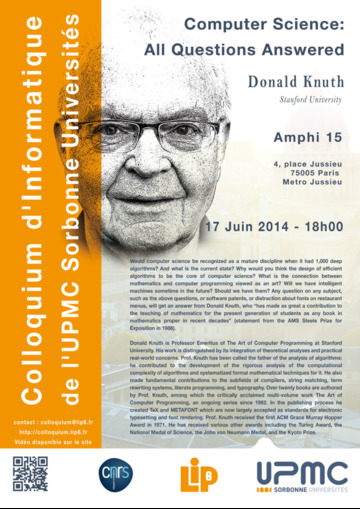

Donald Knuth

Donald Knuth

17 juin 2014

Computer Science: All Questions Answered -

Jeannette Wing

Jeannette Wing

20 mai 2014

Toward a Theory of Trust in Networks of Humans and Computers -

David Patterson

David Patterson

06 mai 2014

Myths about MOOCs and Software Engineering Education -

Claude Berrou

Claude Berrou

25 mars 2014

L'information mentale -

Vint Cerf

Vint Cerf

04 mars 2014

On the Preservation of Digital Information -

C.A.R. (Tony) Hoare

C.A.R. (Tony) Hoare

26 novembre 2013

Laws of concurrent system design -

Gilles Dowek

Gilles Dowek

22 octobre 2013

Are formal methods the future of air traffic control?

(Is there an autopilot on board?)

-

- Année 2012 – 2013

-

Mathieu Feuillet, Camille Couprie, Mathilde Noual

Mathieu Feuillet, Camille Couprie, Mathilde Noual

25 juin 2013

Espoirs : Winners of the 2012 Gilles Kahn prize -

Robert Sedgwick

Robert Sedgwick

23 mai 2013

Taking Education Online: A Unique Opportunity for the New Millenium -

Frans Kaashoek

Frans Kaashoek

18 avril 2013

The multicore evolution and operating systems -

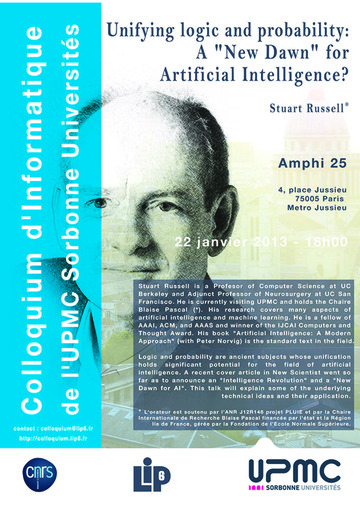

Stuart Russell

Stuart Russell

22 janvier 2013

Unifying logic and probability: A “New Dawn” for Artificial Intelligence? -

Georges Gonthier

Georges Gonthier

27 novembre 2012

Le génie mathématique, du théorème des quatre couleurs à la classification des groupes -

Gérard Berry

Gérard Berry

24 octobre 2012

Le temps et les événements en informatique

-

- Année 2011 – 2012